Autor: Tobias Müller — ispringen.dev

Sprachmodelle neigen dazu, nach dem Training immer ähnliche Antworten zu generieren. Das Problem ist nicht technisch, sondern menschlich. Studien zeigen, dass wir als Bewerter unbewusst typische, vertraute Antworten bevorzugen. Diese Tendenz verstärkt sich im Laufe der Zeit und führt zu weniger vielfältigen KI-Ausgaben. Die Lösung heißt Verbalized Sampling, eine einfache, aber wirksame Prompt-Technik, die Modelle dazu bringt, bewusst vielfältiger zu antworten.

„Wir belohnen Vertrautheit, nicht Vielfalt.“

Die Methode funktioniert ohne zusätzliches Training oder Zugriff auf interne Modellparameter. Statt einer einzelnen Antwort fordert der Prompt mehrere Varianten mit expliziten Wahrscheinlichkeiten an. Das Ergebnis sind kreativere, weniger stereotype Ausgaben, die besser mit menschlichem Verhalten übereinstimmen.

Warum KI-Antworten immer ähnlicher werden

Menschliche Bewertungsmuster sind der Schlüssel zum Problem. Forschende analysierten den HELPSTEER-Datensatz mit 6874 Antwortpaaren. Ihr Befund: Menschen bevorzugen systematisch Antworten, die von Basismodellen als wahrscheinlicher eingestuft werden. Das gilt selbst dann, wenn diese Antworten sachlich falsch sind. Der Effekt zeigte sich in mehreren Datensätzen und bestätigt eine klare Tendenz: Wir belohnen Vertrautheit, nicht Vielfalt.

Diese Präferenz überträgt sich auf die Modelle. Im Training lernen sie, dass „typische“ Antworten höhere Belohnungen erhalten. Mit der Zeit verengen sich die Ausgaben auf ein paar häufige Muster. Bei Witzen führt das dazu, dass dasselbe Modell fünfmal hintereinander den exakt gleichen Witz liefert. Bei kreativen Aufgaben wiederholen sich Storylines oder Gedichtstrukturen. Die Folge ist eine künstliche Stereotypisierung, die wenig mit den eigentlichen Fähigkeiten der Modelle zu tun hat.

So funktioniert Verbalized Sampling

Die Lösung ist überraschend einfach. Statt das Modell nach der Antwort zu fragen, fordert man mehrere Varianten mit zugehörigen Wahrscheinlichkeiten an. Ein typischer Prompt sieht so aus:

<instruction>

Generate 5 responses to the user query, each within a separate <response> tag.

Each <response> must include a <text> and a numeric <probability>.

Randomly sample the responses from the full distribution.

</instruction>

Write a 100-word story about a bear.

Das Team um Zhang entwickelte drei Varianten der Methode:

- Standardversion: Direktes Abfragen mehrerer Antworten mit Wahrscheinlichkeiten.

- Chain-of-Thought (CoT): Schrittweises Reasoning vor der Generierung, um komplexere Vielfalt zu erreichen.

- Multi-turn: Mehrere Gesprächsrunden, in denen das Modell seine Antworten iterativ anpasst.

Alle Varianten benötigen kein zusätzliches Training und keinen Zugang zu internen Modellwahrscheinlichkeiten. Sie nutzen ausschließlich die bestehende Prompt-Schnittstelle.

Messbare Verbesserungen in Kreativität und Realismus

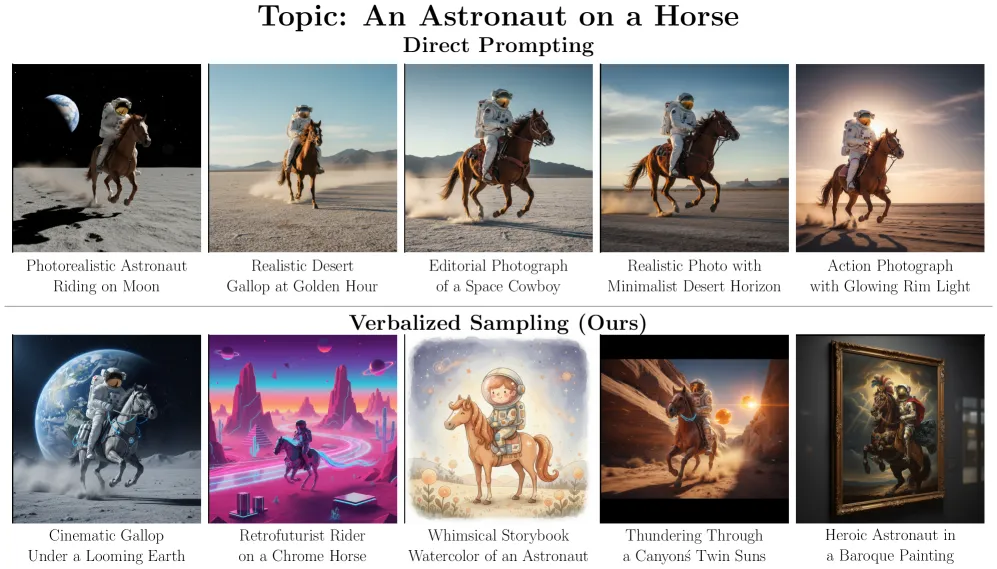

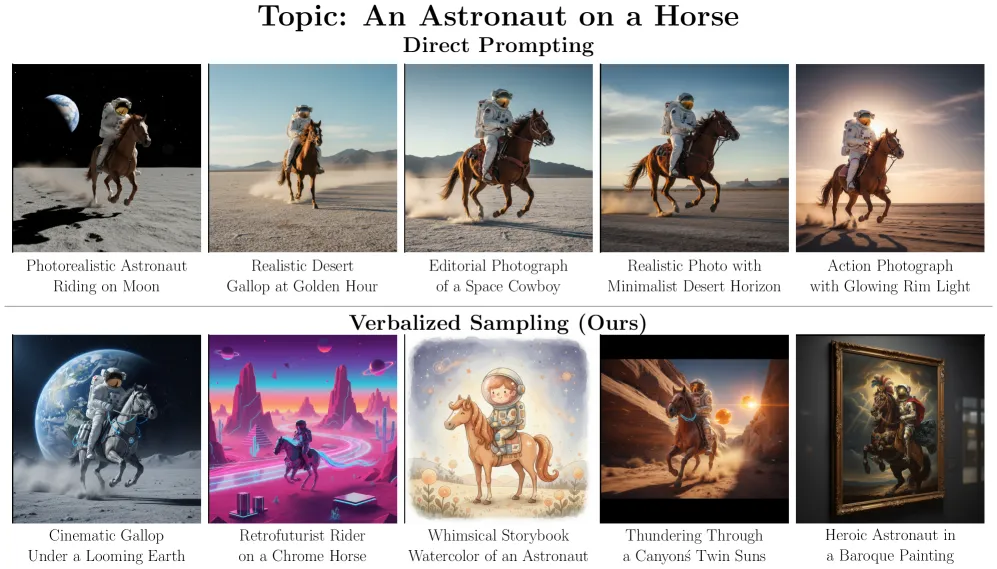

Abbildung: Vergleich zwischen Direct Prompting und Verbalized Sampling aus Zhang et al., 2025.

Tests zeigen deutliche Effekte. Bei kreativen Schreibaufgaben stieg die semantische Diversität um das 1,6- bis 2,1-fache.

„Mit Verbalized Sampling entstanden fünf völlig unterschiedliche Witze, statt fünfmal demselben.“

Ein einfacher Witz-Prompt wie „Tell a joke about cars“ lieferte mit Standardmethoden fünfmal dieselbe Antwort:

„Why did the car get a flat tire? Because it ran over a fork in the road!“

Mit Verbalized Sampling entstanden fünf völlig unterschiedliche Witze, darunter:

„What kind of car does a Jedi drive? A Toy-Yoda!“

Auch in Dialogsimulationen zeigte sich ein realistischeres Verhalten. Modelle widerstanden Überzeugungsversuchen plausibler und änderten Meinungen graduell, ähnlich wie Menschen. Bei Spendensimulationen stimmten die Ergebnisse besser mit echten menschlichen Entscheidungen überein.

Offene Fragen wie „Name a US state“ ergaben mit Standard-Prompts fast immer Kalifornien oder Texas. Verbalized Sampling verteilt die Antworten dagegen gleichmäßiger über alle 50 Staaten, entsprechend der ursprünglichen Trainingsdaten.

Praktische Empfehlungen für den Einsatz

Die Methode profitiert besonders von größeren Modellen. Bei GPT-4.1 und Gemini-2.5-Flash waren die Verbesserungen 1,5- bis 2-mal höher als bei kleineren Versionen. Verbalized Sampling lässt sich zudem mit anderen Generierungsparametern kombinieren, etwa der Temperatureinstellung. Tests zeigen, dass es unabhängig von diesen Parametern funktioniert und gleichzeitig deren Wirkung verstärkt.

Für die Bildgenerierung erzeugte die Technik vielfältigere Beschreibungen. Während Standard-Prompts zu „Astronaut on a Horse“ durchweg fotorealistische Wüstenszenen lieferten, entstanden mit Verbalized Sampling Beschreibungen für:

- Retro-Futurismus-Stile

- Aquarellmalereien

- barocke Gemälde

Die Sicherheit bleibt dabei gewahrt. Tests mit über 350 problematischen Prompts ergaben Ablehnungsraten von über 97 Prozent. Auch die Faktentreue litt nicht unter der größeren Vielfalt.

Die Forschenden haben Code und Anleitungen veröffentlicht. Anwendungsbereiche sehen sie vor allem in:

- kreativem Schreiben (Geschichten, Gedichte, Drehbücher)

- sozialer Simulation (Dialoge, Verhandlungsübungen)

- Ideengenerierung (Produktdesign, Marketingkonzepte)

Zitierhinweis

Dieser Artikel kann wie folgt zitiert werden:

Tobias Müller (2025): Ein einzelner Prompt soll langweilige KI-Antworten verhindern ispringen.dev. Abgerufen am 25.10.2025.

Quellen

Zhang, J., Yu, S., Chong, D., Sicilia, A., Tomz, M. R., Manning, C. D. & Shi, W. (2025).

Verbalized Sampling: How to Mitigate Mode Collapse and Unlock LLM Diversity.

arXiv:2510.01171v3, veröffentlicht am 10. Oktober 2025.

https://arxiv.org/abs/2510.01171v3

CHATS-Lab (2025).

Verbalized Sampling – Project Website & Code Repository.

https://www.verbalized-sampling.com/

Kemper, J. (2025).

Ein einzelner Prompt soll langweilige KI-Antworten verhindern.

The Decoder, 25. Oktober 2025.

https://the-decoder.de/ein-einzelner-prompt-soll-langweilige-ki-antworten-verhindern/